MUNDO

Entenda como funciona o chatGPT e suas limitações

O ChatGPT é o mais recente modelo de idioma do OpenAI e representa uma melhoria significativa em relação ao seu antecessor GPT-3. Da mesma forma que muitos modelos de idiomas grandes, o ChatGPT é capaz de gerar texto em uma ampla gama de estilos e para fins diferentes, mas com precisão, detalhe e coerência notavelmente maior. Ele representa a próxima geração na linha de grandes modelos de idiomas da OpenAI e foi projetada com um forte foco em conversas interativas.

Os criadores usaram uma combinação de aprendizado supervisionado e aprendizado de reforço para ajustar o ChatGPT, mas é o componente de aprendizado de reforço especificamente que torna o ChatGPT único. Os criadores usam uma técnica específica chamada Aprendizagem de Reforço com o Feedback Humano (RLHF), que usa feedback humano no ciclo de treinamento para minimizar resultados prejudiciais, invertidos e/ou tendenciosos.

Capacidade vs alinhamento em grandes modelos de linguagem

No contexto do aprendizado de máquina, o termo capacidade refere -se à capacidade de um modelo de executar uma tarefa ou conjunto específico de tarefas. A capacidade de um modelo é normalmente avaliada por quão bem é capaz de otimizar sua função objetiva, a expressão matemática que define o objetivo do modelo.

Por exemplo, um modelo projetado para prever os preços do mercado de ações pode ter uma função objetiva que mede a precisão das previsões do modelo. Se o modelo for capaz de prever com precisão o movimento dos preços das ações ao longo do tempo, consideraria -se ter um alto nível de capacidade para esta tarefa.

O alinhamento, por outro lado, está preocupado com o que realmente queremos que o modelo faça versus o que está sendo treinado para fazer. Ele faz a pergunta “Essa função objetiva é consistente com nossas intenções?” e refere -se à medida em que os objetivos e o comportamento de um modelo se alinham aos valores e expectativas humanas.

Para um exemplo concreto simples, digamos que treinamos um classificador de pássaros para classificar os pássaros como “pardais” ou “robins” e usamos perda de log (que mede a diferença entre a distribuição de probabilidade prevista do modelo e a verdadeira distribuição) como o treinamento Objetivo, mesmo que nosso objetivo final seja uma alta precisão de classificação.

O modelo pode ter baixa perda de log, ou seja, a capacidade do modelo é alta, mas baixa precisão no conjunto de testes. De fato, a perda de log não está perfeitamente correlacionada com a precisão das tarefas de classificação. Este é um exemplo de desalinhamento, onde o modelo é capaz de otimizar o objetivo do treinamento, mas pouco alinhado com nosso objetivo final.

Modelos de idiomas grandes, como o GPT-3, são treinados em grandes quantidades de dados de texto da Internet e são capazes de gerar texto semelhante ao humano, mas nem sempre podem produzir saída consistente com expectativas humanas ou valores desejáveis. De fato, sua função objetiva é uma distribuição de probabilidade sobre sequências de palavras (ou seqüências de token) que lhes permite prever qual está a próxima palavra em uma sequência (mais detalhes sobre isso abaixo).

Em aplicações práticas, no entanto, esses modelos têm como objetivo executar alguma forma de trabalho cognitivo valioso, e há uma clara divergência entre a maneira como esses modelos são treinados e a maneira como gostaríamos de usá -los.

Embora uma máquina calculada distribuição estatística das sequências de palavras possa ser matematicamente falando, uma escolha muito eficaz para modelar a linguagem, nós, como humanos Este processo. Isso pode ser um problema quando os modelos de idiomas são usados em aplicativos que exigem um alto grau de confiança ou confiabilidade, como sistemas de diálogo ou assistentes pessoais inteligentes.

Leia também: 5 Curiosidades sobre o iPhone que muitas pessoas não sabem

As limitações do chatGPT

Embora esses modelos poderosos e complexos treinados em grandes quantidades de dados tenham se tornado extremamente capazes nos últimos anos, quando usados em sistemas de produção para facilitar a vida humana, eles geralmente ficam aquém desse potencial. O problema de alinhamento em grandes modelos de linguagem normalmente se manifesta como:

- Falta de utilidade: não seguir as instruções explícitas do usuário.

- Alucinações: Modelo comprovando fatos não históricos ou errados.

- Falta de interpretabilidade: é difícil para os seres humanos entender como o modelo chegou a uma decisão ou previsão específica.

- Gerando saída tendenciosa ou tóxica: um modelo de idioma que é treinado em dados tendenciosos/tóxicos pode reproduzir isso em sua saída, mesmo que não tenha sido explicitamente instruído a fazê -lo.

Créditos do texto: AssemblyAI

-

Concursos2 anos Atrás

Concursos2 anos AtrásConcurso Literário 2023 – Inscrições, Vagas

-

Concursos1 ano Atrás

Concursos1 ano AtrásConcurso REDA 2023 – Inscrições, Edital, Vagas

-

Concursos1 ano Atrás

Concursos1 ano AtrásConcurso Jornalista 2023 – Dicas, como se inscrever, editais

-

Concursos1 ano Atrás

Concursos1 ano AtrásConcurso Copasa 2023 – Inscrições, Edital, Vagas

-

Dicas1 ano Atrás

Dicas1 ano Atrás2 Via Conta Embratel – Consulta, Emissão, Imprimir

-

Concursos1 ano Atrás

Concursos1 ano AtrásConcurso Correios 2023 – Inscrições, Edital, Vagas

-

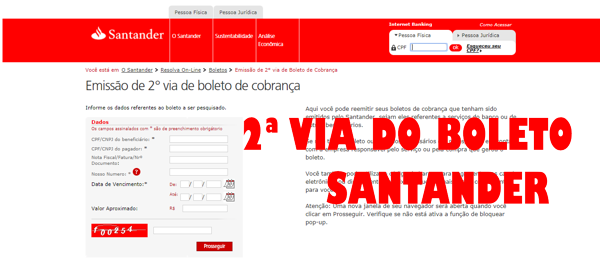

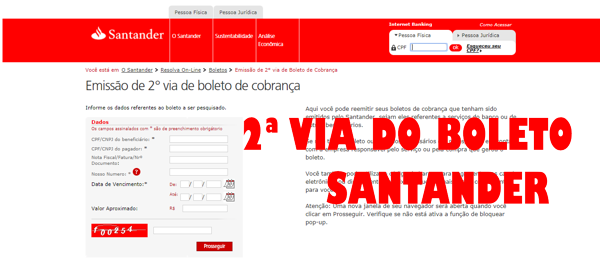

Dicas11 meses Atrás

Dicas11 meses Atrás2 Via Boleto Santander – Consulta, Emissão, Imprimir

-

Concursos2 anos Atrás

Concursos2 anos AtrásSe você deseja prestar Concurso para Bombeiro em 2023, esse artigo merece ser lido!

-

Concursos1 ano Atrás

Concursos1 ano AtrásConcurso para Professor 2023 – Inscrições, Edital, Vagas

-

Dicas2 anos Atrás

Dicas2 anos Atrás2 Via Conta Enel 2023- Emissão, Solicitar, Imprimir

-

Concursos1 ano Atrás

Concursos1 ano AtrásConcurso SEDUC 2023 – Inscrições, Edital, Vagas

-

Concursos3 anos Atrás

Concursos3 anos AtrásConcurso Prefeitura Salvador 2022 – Inscrições, Edital, Vagas

-

Carreira3 anos Atrás

Carreira3 anos AtrásVagas Abertas ICOMON 2022 – Trabalhe Conosco, Requisitos, Seleção

-

Carreira10 meses Atrás

Carreira10 meses AtrásVagas Abertas Lavoisier 2024 – Trabalhe Conosco, Requisitos, Seleção

-

TV2 anos Atrás

TV2 anos AtrásPrograma João Kléber Show – Inscrição, Quadros, Participe

-

Eventos3 anos Atrás

Eventos3 anos AtrásShow da Gabriela Rocha 2022 – Ingressos, Datas, Locais

-

Renda3 anos Atrás

Renda3 anos AtrásImposto de Renda PLR 2022 – Consultar, Programa, Duvidas

-

Concursos3 anos Atrás

Concursos3 anos AtrásConcurso UPA 2022 – Inscrições, Edital, Vagas

-

Concursos3 anos Atrás

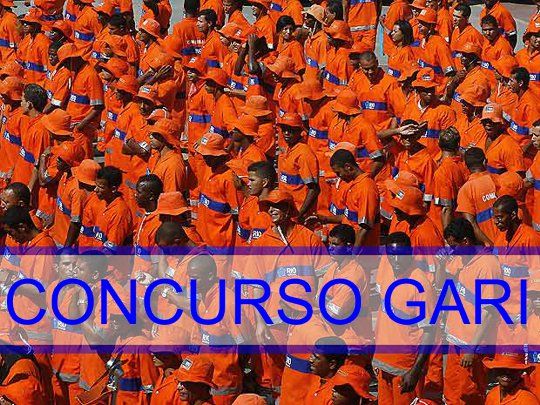

Concursos3 anos AtrásConcurso Gari 2022 – Inscrições, Edital, Vagas

-

Trânsito2 anos Atrás

Trânsito2 anos Atrás2 Via Do Ipva 2023- Como Consultar, Imprimir e efetuar o pagamento no seu Banco